Neues Tool zur Erzeugung und Design von Proteinsequenzen

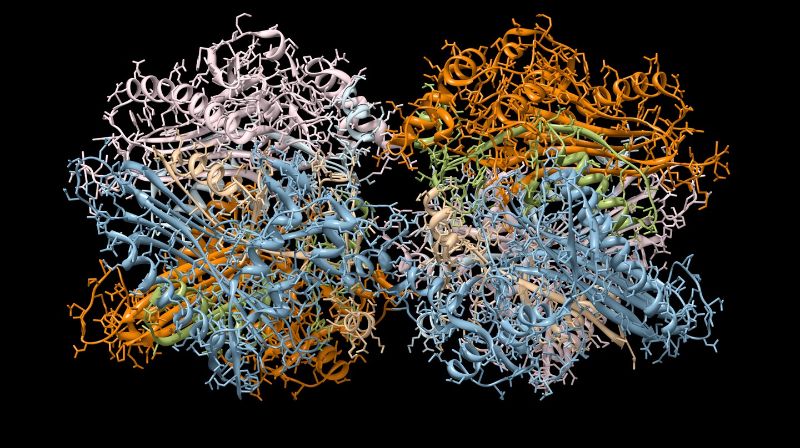

Die Entwicklung neuer Proteine mit spezifischer Struktur und Funktion ist ein sehr wichtiges Ziel des Bioengineering, aber die enorme Grösse des Proteinsequenzraums erschwert die Suche nach neuen Proteinen. Eine neue Studie der Gruppe von Anne-Florence Bitbol an der EPFL-Fakultät für Life Sciences hat jedoch ergeben, dass ein neuronales Deep-Learning-Netzwerk, MSA Transformer, eine vielversprechende Lösung sein könnte.

MSA Transformer wurde 2021 entwickelt und funktioniert ähnlich wie die natürliche Sprachverarbeitung, die von dem inzwischen berühmten ChatGPT verwendet wird. Das Team, bestehend aus Damiano Sgarbossa, Umberto Lupo und Anne-Florence Bitbol, hat eine «iterative Methode» vorgeschlagen und getestet, die auf der Fähigkeit des Modells beruht, fehlende oder verdeckte Teile einer Sequenz auf der Grundlage des umgebenden Kontexts vorherzusagen.

Das Team fand heraus, dass MSA Transformer durch diesen Ansatz zur Generierung neuer Proteinsequenzen aus gegebenen Protein-«Familien» (Gruppen von Proteinen mit ähnlichen Sequenzen) verwendet werden kann, die ähnliche Eigenschaften wie natürliche Sequenzen haben.

Tatsächlich wiesen Proteinsequenzen, die aus grossen Familien mit vielen Homologen generiert wurden, bessere oder ähnliche Eigenschaften auf als Sequenzen, die mit Potts-Modellen generiert wurden. «Ein Potts-Modell ist eine ganz andere Art von generativem Modell, das nicht auf natürlicher Sprachverarbeitung oder Deep Learning basiert und vor kurzem experimentell validiert wurde», erklärt Bitbol. «Mit unserem neuen, auf MSA Transformer basierenden, Ansatz konnten wir Proteine sogar aus kleinen Familien generieren, in denen Potts-Modelle schlecht abschneiden.»

Der MSA-Transformer reproduziert die Statistiken höherer Ordnung und die Verteilung von Sequenzen in natürlichen Daten genauer als andere Modelle, was ihn zu einem starken Kandidaten für die Generierung von Proteinsequenzen und das Proteindesign macht.

«Diese Arbeit kann zur Entwicklung neuer Proteine mit spezifischen Strukturen und Funktionen führen; solche Ansätze werden hoffentlich in Zukunft wichtige medizinische Anwendungen ermöglichen», sagt Bitbol. «Das Potenzial des MSA-Transformers als starker Kandidat für das Proteindesign bietet aufregende neue Möglichkeiten für das Gebiet des Bioengineering.»

Die Studie wurde in der Zeitschrift eLife veröffentlicht, deren Redakteure kommentierten: «Diese wichtige Studie schlägt eine Methode vor, um neuartige Sequenzen aus einem Protein-Sprachmodell zu entnehmen, die aufregende Anwendungen im Proteinsequenzdesign haben könnte. Die Behauptungen werden durch ein solides Benchmarking der entworfenen Sequenzen in Bezug auf Qualität, Neuartigkeit und Vielfalt gestützt.»