Plus vite et intelligemment

La carrière de chercheur d’Alun Ashton a débuté dans les années 1990, une sorte d’âge de pierre, du moins en ce qui concerne l’utilisation des ordinateurs. «Etudiant, j’enregistrais les données de mes mesures sur des disquettes», se souvient le biochimiste et informaticien. Pour tous ceux qui ne le savent pas, les disquettes étaient des supports de stockage magnétiques amovibles qui, dans leur version la plus moderne, possédaient une capacité de 1,4 mégaoctet. «Si je devais enregistrer sur de tels supports les données générées lors d’une seule expérience à la Source de Lumière Suisse SLS, je devrais en employer des millions et disposer de plusieurs vies pour m’en servir.»

La technologie de l’information s’est heureusement développée si vite qu’Alun Ashton peut utiliser son temps à des choses plus sensées. Même les grandes quantités de données issues des expériences du PSI sont traitées et stockées de façon suffisamment rapide. Du moins jusqu’ici. Les chercheurs du PSI auront un problème en 2025 au plus tard, après l’upgrade de la SLS et l’entrée en fonction de la SLS 2.0. Les expériences pourront alors avoir une performance jusqu’à mille fois supérieure à celle de la SLS actuelle ainsi que d’autres configurations et livrer ainsi beaucoup plus de données. S’y ajouteront des détecteurs de meilleure qualité, et plus rapides et dotés d’une résolution plus élevée. Là où la ligne de faisceau de la SLS actuelle produit un jeu de données par minute, la SLS 2.0 fournira la même quantité de données en moins d’une seconde. Le tout nouveau détecteur Jungfrau, au SwissFEL, peut même produire à pleine vitesse 50 gigaoctets par seconde, alors qu’un disque dur d’ordinateur classique serait déjà rempli en quelques secondes. Dans leur ensemble, les expériences au PSI génèrent actuellement 3,6 pétaoctets par an. Quand la SLS 2.0 sera en fonction, les expériences qui y seront menées produiront à elles seules jusqu’à 30 pétaoctets par an, pour lesquels quelque 50000 disques durs seraient nécessaires. Avec des disquettes, on pourrait facilement ajouter six zéros à ce chiffre.

Chercher des idées fraîches

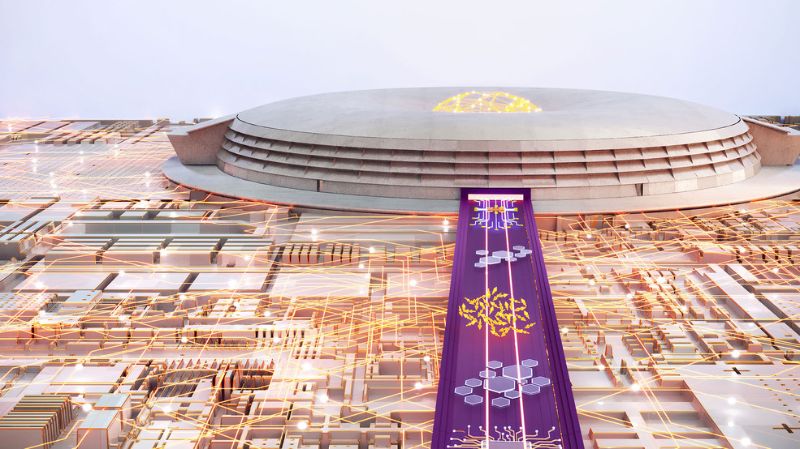

Une chose est claire: au PSI, ces nouveaux défis ne seront pas relevés avec de vieux concepts. Il faut des idées fraîches sur la façon de maîtriser les gigantesques quantités de données dues aux interrogations de la recherche, de plus en plus exigeantes et nombreuses. Et il faut un axe de recherche propre avec une structure organisationnelle adaptée. La nouvelle division Calcul scientifique, théorie et données (SCD), créée en juillet 2021, répond à cet impératif. La SCD réunit des unités déjà existantes comme le Laboratoire de simulation et de modélisation, dirigé par intérim par Andreas Adelmann, mais aussi de nouvelles unités comme le troisième site du Swiss Data Science Center au PSI, qui vient compléter les deux sites existant à l’Ecole polytechnique fédérale de Lausanne (EPFL) et à l’Ecole polytechnique fédérale de Zurich (ETHZ). Environ septante personnes effectuent de la recherche, développent et apportent leur soutien au sein de ces quatre entités. Elles seront bientôt une centaine. Alors que les trois chefs de laboratoire Andreas Adelmann, Andreas Läuchli et Nicola Marzari se consacrent principalement aux méthodes scientifiques dans leurs disciplines respectives, Alun Ashton, à la tête du département Science IT Infrastructure and Services, dirige une unité qui appuie techniquement, en matière de calcul scientifique, les chercheurs et chercheuses du domaine des sciences photoniques, de la SCD et du PSI en général.

«Les départements doivent mener des recherches et ne pas gérer leurs propres services informatiques », indique Alun Ashton. C’est pourquoi la centralisation au sein de la SCD est la bonne option. «On ne réinvente pas la roue, mais nous avons avec la SCD un atout unique, renchérit Andreas Adelmann. La nouvelle division de recherche exploite mieux les synergies, elle a un rayonnement international et attire des personnes de qualité. Elle est davantage que la somme de ses parties.»

L’un de ses «clients» les plus intéressants est Marco Stampanoni, constate Alun Ashton avec un clin d’oeil. L’équipe du professeur de l’ETH se consacre à la microtomographie à rayons X, qui est très exigeante en matière de puissance de calcul et de capacité de stockage. Pour étudier par exemple comment, lors de la synthèse d’un nouvel alliage, un gaz chaud s’introduit dans une mousse liquide métallique, le logiciel doit, pour chaque milliseconde, calculer un instantané en trois dimensions des données. Les quantités de données générées et traitées sont énormes. D’autres collègues du même laboratoire s’occupent de microscopie computationnelle et, en particulier, de ptychographie. Celle-ci remplace la microscopie à rayons X conventionnelle qui utilise des lentilles mais qui n’atteint pas une résolution aussi précise. Avec la ptychographie, un algorithme itératif reconstruit la radiographie à partir des données brutes du détecteur, qui est éloigné de l’échantillon, sans qu’une lentille se trouve entre eux, et qui utilise les propriétés cohérentes d’une source de lumière synchrotron. L’opération mathématique qui se trouve à la base est très exigeante en termes de calcul et doit être exécutée un millier de fois. A la SLS 2.0, les exigences en matière de puissance de calcul augmenteront considérablement, ce qui rend le recours au superordinateur du Centre suisse de calcul scientifique (CSCS) de Lugano indispensable.

Ne plus se fier à la loi de Moore

Et cet écart de performance devrait croître encore. En effet, les chercheurs du PSI et ceux de nombreuses autres disciplines des sciences naturelles ne peuvent plus se fier à la loi de Moore. En 1965, le cofondateur d’Intel, Gordon Earle Moore, avait prédit que le nombre de transistors – qui correspond plus ou moins à la puissance de calcul – allait doubler tous les dix-huit mois (selon certaines sources, douze ou vingt-quatre mois). La loi de Moore est toujours actuelle et le sera encore pendant cette décennie. Mais cela ne suffit malheureusement pas. «La brillance des sources comme le SwissFEL ou la SLS 2.0 augmente plus vite que la loi de Moore, avertit Marco Stampanoni. Nous avons besoin de solutions plus intelligentes qu’une simple hausse de la puissance de calcul.»

Cela pourrait être l’apprentissage automatique. «C’est un truisme. Nos données contiennent bien plus que ce que nous avons pu exploiter jusqu’ici», affirme Andreas Adelmann. L’apprentissage automatique pourrait permettre de découvrir ce qui se cache dans ces montagnes de données. Et contribuer à épargner le précieux temps de rayonnement de la SLS et du SwissFEL. Après leurs mesures, les expérimentateurs emportaient autrefois leurs données chez eux pour les analyser au calme. Mais des expériences pouvaient mal se passer et l’on ne s’en rendait compte qu’après des mois. Des modèles rapides fondés sur l’apprentissage automatique peuvent dire pendant l’expérience en cours si les valeurs mesurées sont plausibles. Dans le cas contraire, l’expérimentateur a le temps d’ajuster son dispositif de mesure. «La collecte des données et leur analyse se rapprochent», lance Andreas Adelmann.

Marco Stampanoni considère la SCD comme un partenaire important. L’informatique n’est pas la tasse de thé de beaucoup d’utilisateurs et de chercheurs, qui peuvent se montrer dépassés. «Un médecin n’est pas obligé de savoir comment fonctionne un synchrotron ou comment et où exactement les données sont stockées.» S’il s’intéresse à l’effet d’un médicament sur la solidité des os, il ne veut pas devoir étudier un jeu de données de 10 téraoctets livré par une expérience tomographique menée au synchrotron. Un simple graphique avec les principaux résultats lui suffit. «La SCD fournira là une contribution permettant aux usagers de résoudre leurs problèmes de données et d’atteindre des résultats scientifiques dans un délai raisonnable», espère Marco Stampanoni.

Utiliser des synergies

Xavier Deupi est certain que cela va marcher. Pour le scientifique du groupe de recherche Théorie de la matière condensée, la création de la SCD était inéluctable: «Le PSI avait besoin de consolider le calcul scientifique au sein d’une entité organisationnelle, afin de pouvoir exploiter des synergies.» Les scientifiques des données sont maintenant réunis dans la même division. Ils peuvent répondre plus rapidement aux questions de son équipe et lancer des projets communs. «Grâce à leur savoir-faire informatique et à nos connaissances en biologie, de nouveaux outils sont créés pour étudier les protéines.»

Xavier Deupi se décrit lui-même comme un «heavy user» du puissant ordinateur Merlin du PSI et du superordinateur de Lugano. Pour une expérience, il fait appel à des centaines de processeurs qui fonctionnent pendant autant d’heures et parfois même pendant des mois. Mais ce n’est pas suffisant: malgré cette longue durée de calcul, il ne peut simuler que des changements de quelques microsecondes dans les protéines. Mais lorsqu’une molécule se lie à une protéine, par exemple l’adrénaline à des récepteurs dans les cellules cardiaques, cela dure au moins quelques millisecondes. Un tiers de tous les médicaments se lient aux protéines qu’il étudie. Si l’on pouvait observer l’ensemble du processus dans une vidéo en 3D, ce serait une percée pour le développement de ceux-ci. Cependant, même les ordinateurs les plus puissants ne sont pas encore en mesure de le faire.

Mais pourquoi faire compliqué quand on peut faire simple? Nombreux sont ceux qui se posent la question depuis que Google a présenté, avec AlphaFold, un logiciel qui, grâce à l’intelligence artificielle, analyse des modèles de telles protéines beaucoup plus rapidement et précisément. On n’entre que la séquence et AlphaFold «recrache» la structure. «AlphaFold, c’est très bien, se félicite Xavier Deupi. La fin de la biologie structurale, prophétisée par certains, n’est toutefois pas encore en vue.» Il n’a pas non plus peur de perdre son poste. L’algorithme de Google ne dévoile pas l’entièreté de la structure d’une protéine et l’on ne peut pas simplement en déduire la fonction. «AlphaFold ne dit pas comment les protéines bougent.» C’est pourquoi les grandes installations de recherche, comme la SLS et le SwissFEL, continuent d’être nécessaires. «AlphaFold ne remplace pas ces machines, il les complète.»

Accompagner le changement

La SCD est le lieu idéal pour tester ces nouveaux outils. Dans cette intention, expérimentateurs, théoriciennes, experts en informatique, ingénieures et autres… doivent se parler. Marie Yao estime que c’est nécessaire afin que les informaticiens trouvent les bonnes solutions pour eux. Elle a été engagée au sein de la SCD pour surmonter les problèmes de communication et accompagner le changement en vue des meilleurs résultats scientifiques possible. Si elle travaillait dans une entreprise, elle se qualifierait de «manager d’alliances stratégiques ». «Le changement n’est pas toujours simple», remarque celle qui a occupé, pendant plusieurs années, un poste semblable au Oak Ridge National Laboratory (USA). Certains collaborateurs ont peur de perdre de l’influence et s’accrochent aux vieux processus. Sa tâche consiste à encourager le travail en équipe et à créer un environnement où tous et toutes se sentent en sécurité et appréciés grâce à leur contribution à de meilleures solutions techniques.

Dans l’équipe d’Alun Ashton, à l’interface entre la SCD et les autres divisions du PSI, Marie Yao coordonne aussi les développements pour le lancement de la SLS 2.0 en 2025 et contribue à l’élaboration de solutions techniques. D’ici là, hardware, software et réseaux devront être prêts à gérer d’énormes quantités de données. Pour la jeune femme, une approche globale est importante. «La solidité du pipeline de données dépend de son maillon le plus faible.»

En science comme dans d’autres secteurs économiques, c’est le manque de personnel qualifié qui représente de plus en plus ce maillon faible. Lorsque les experts font défaut, il faut les former, souvent dans des domaines interdisciplinaires. «La société nous donne des experts compétents, nous devrions donc lui rendre quelque chose. L’une des possibilités est de nous engager dans la formation de la prochaine génération», fait-elle valoir.

Les chercheurs de demain ont du pain sur la planche. Les logiciels pour répondre aux interrogations de la science sont souvent vieux de vingt ans et partiellement inefficaces. Combler les déficits en augmentant encore la puissance de calcul ne fonctionne plus aujourd’hui. Les logiciels scientifiques doivent être perfectionnés pour faire face à la croissance rapide des données et à des évolutions comme l’utilisation de processeurs graphiques au lieu d’unités centrales de calcul et de commande conventionnelles. «La SCD peut contribuer à attirer des gens capables de le faire», argue Marie Yao.

Machine et modélisation

Pour Andreas Läuchli, c’est déjà gagné. Aux côtés d’Andreas Adelmann et de Nicola Marzari, il est le troisième chef de laboratoire scientifique au sein de la SCD, où il s’occupe de physique théorique et numérique. Venu d’Innsbruck, il est arrivé voici un an au PSI et à l’EPFL, où il dirige une chaire. Il doit renforcer le volet théorique, mais aussi travailler main dans la main avec les physiciens expérimentaux et leur donner des idées pour de nouvelles expériences, notamment au SwissFEL et à la SLS 2.0. «Les expériences et la théorie deviennent de plus en plus complexes. Qui veut mener et publier des recherches avec succès a besoin d’une bonne machine et d’une bonne modélisation.» La SCD est, selon lui, un élément important de cette synthèse.

Son dada, ce sont les systèmes pluriparticules: ce qui, en physique, comprend plus d’un seul atome d’hydrogène et, donc, presque l’ensemble de la matière. Tous les chemins pour déterminer les niveaux d’énergie dans ces systèmes passent par l’équation de Schrödinger. Si celle-ci fournit des résultats exacts pour l’atome d’hydrogène, l’effort de calcul croît de façon exponentielle pour les systèmes pluriparticules. C’est pourquoi les chercheurs se rabattent sur des approximations avec quelques atomes, mais il n’est pas toujours sûr que celles-ci soient suffisamment proches de la réalité.

Andreas Läuchli utilise alors un levier, la méthode dite de la «force brute». Avec une puissance de calcul massive, il brise l’équation de Schrödinger avec jusqu’à cinquante particules. 20000 noyaux de processeurs, avec plusieurs téraoctets de mémoire vive, travaillent simultanément pendant plusieurs semaines. Même le superordinateur de Lugano est bloqué, pendant un temps, pour d’autres utilisateurs. «La méthode de la force brute est parfois importante pour vérifier si nos approximations sont valables», précise-t-il.

Naturellement, il n’est pas possible d’avoir recours au calculateur de façon spontanée. Chaque équipe doit déposer une demande étoffée à Lugano, qui est évaluée en fonction du gain de connaissances scientifiques et de l’efficience des algorithmes. L’utilisation du superordinateur Merlin, au PSI, est moins bureaucratique, mais celui qui y a consommé beaucoup de temps de calcul sera recalé et devra d’abord se mettre au bout de la file d’attente.

Andreas Läuchli place de grands espoirs dans le Quantum Computing Hub (QCH), créé en 2021 au PSI. «Peut-être qu’à l’avenir nous pourrons rendre compte sur des ordinateurs quantiques de problèmes de physique non calculables sur des ordinateurs classiques.» Le hub devrait aussi profiter de la collaboration avec la SCD, car les ordinateurs quantiques sont fondés sur les principes physiques étudiés par Andreas Läuchli et son équipe. «J’y vois un grand potentiel», conclut-il.