Suivre des animaux grâce à l'apprentissage profond

En neurosciences, en écologie, mais aussi dans de nombreux autres domaines, il est essentiel de pouvoir enregistrer les comportements d’animaux. Si les caméras sont particulièrement adaptées à la capture de détails comportementaux très précis, la mise au point de techniques de vision par ordinateur permettant dextraire le comportement d’un animal à partir de vidéos constitue un véritable défi, même si cette tâche semble ne poser aucune difficulté à notre propre système de vision.

L’un des aspects clés de la quantification du comportement animal est l’« estimation de pose », terme qui se réfère à la capacité d’un ordinateur à identifier la position et l’orientation des différentes parties du corps d’un animal. En laboratoire, on peut faciliter l’estimation de pose en plaçant des marqueurs sur le corps d’un animal comme dans les techniques de capture de mouvement utilisées au cinéma (pensez à Gollum dans Le Seigneur des anneaux). Mais comme on peut l’imaginer, il n’est pas facile de faire porter des équipements spécialisés à des animaux — et en pleine nature, cela devient franchement impossible, et contraire à l’éthique.

C’est pour cette raison qu’Alexander Mathis et Mackenzie Mathis, tous deux professeurs à l’EPFL, ont conçu un suivi «sans marqueur» pour les animaux. Le logiciel qu’ils ont développé utilise l’apprentissage profond pour «apprendre» aux ordinateurs à reconnaître les parties du corps d’animaux sans avoir besoin pour cela de marqueurs physiques ou virtuels.

Leurs équipes ont mis au point DeepLabCut, un «progiciel d’estimation de pose» basé sur l’apprentissage profond et en accès libre, capable d’effectuer une capture de mouvement d’animaux sans marqueur. En 2018, ils lançaient DeepLabCut: depuis lors téléchargé plus de 350,000 fois et cité dans près de 1400 publications, le logiciel a effectué une percée importante dans le domaine des sciences de la vie. En 2020, les équipes des Mathis publiaient DeepLabCut-Live!, une version en temps réel de DeepLabCut, qui permet aux chercheurs de donner rapidement des feedbacks aux animaux qu’ils sont en train d’étudier.

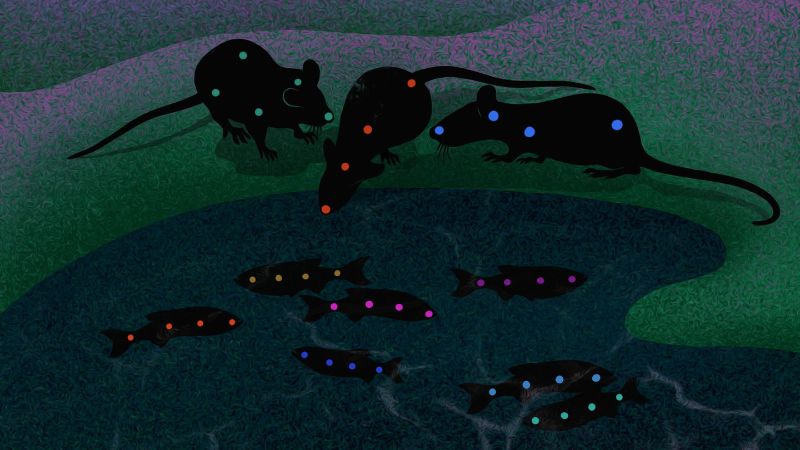

Les scientifiques ont désormais enrichi DeepLabCut pour répondre à un autre défi en matière d’estimation de pose: le suivi d’animaux sociaux, y compris de groupes en interaction étroite tels que des souris s’occupant de leurs petits ou des poissons se déplaçant en bancs. On voit bien où sont les difficultés en la matière: les différents animaux peuvent être morphologiquement si semblables qu’ils «embrouillent» l’ordinateur, ils peuvent s’occulter les uns les autres, et les chercheurs peuvent par ailleurs vouloir effectuer le suivi de nombreux «points clés», ce qui complique sur le plan informatique le traitement efficace des parties suivies par l’ordinateur.

Pour relever ce défi, les équipes de recherche ont commencé par créer quatre ensembles de données de difficulté variable pour évaluer les réseaux d’estimation de pose multi-animaux. Ces ensembles de données, recueillis avec des collègues du MIT et de l’université de Harvard, consistent en trois souris évoluant en terrain ouvert, des souris en cage s’occupant de leurs petits, plusieurs couples de ouistitis vivant dans un grand enclos et, enfin, quatorze poissons dans un aquarium. À partir de ces ensembles de données, les chercheuses et chercheurs ont pu développer de nouvelles méthodes permettant de résoudre les difficultés du suivi d’animaux en contexte réel.

DeepLabCut est parvenu à relever ces défis en intégrant de nouvelles architectures de réseau et des méthodes de suivi de pose sur mesure. Plus précisément, les chercheuses et chercheurs ont créé un nouveau réseau neuronal multitâche capable de prédire, à partir d’une seule image, la présence de points clés, de parties du corps, ainsi que l’identité d’un animal. Ils ont également élaboré un algorithme d’assemblage de ces points clés sans a priori quant à la forme du corps des individus étudiés, ce qui est très important lorsqu’on travaille avec des animaux ayant des morphologies susceptibles de varier considérablement. Ces méthodes ont été validées sur des types d’animaux très divers — de poissons jusqu’à des primates.

En outre, les scientifiques ont mis au point une méthode permettant d’identifier des animaux individuellement à partir de vidéos sans données d’identité «réelles». «Imaginez la difficulté qu’il y a à étiqueter de manière fiable telle ou telle souris de laboratoire», pointe Mackenzie Mathis. «Elles se ressemblent tellement à l’œil nu que c’est une tâche quasi impossible».

Fondé sur un système d’apprentissage métrique avec transformeurs de vision, le nouvel algorithme permet même aux scientifiques de réidentifier des animaux et de continuer à les suivre lorsqu’ils sont occultés un temps par d’autres individus ou sortent du champ des caméras. Les chercheurs ont également utilisé une méthode fondée sur l’apparence pour analyser le comportement de couples de ouistitis à travers neuf heures de vidéo, soit près d’un million d’images. Cette approche a notamment permis de découvrir que ces animaux particulièrement sociaux aiment regarder ensemble dans des directions similaires.

«Dans le monde entier, des centaines de laboratoires utilisent DeepLabCut pour analyser toutes sortes de choses, des expressions faciales chez la souris à la façon dont des primates tendent le bras», explique Alexander Mathis. «Je suis vraiment curieux de voir ce que la communauté scientifique pourra faire grâce à cette boîte à outils élargie qui permet désormais l’analyse d’interactions sociales!»